Robots.txt dibuat agar content website tidak diindeks

Jika kita tidak membuat file robots.txt, maka semua content website blog akan dirayapi dan diindeks oleh robot search engine. Tetapi bagi webmaster (admin website) dan Blogger profesional tidak akan menghendaki hal demikian. Mereka sadar bahwa tidak semua content boleh dirayapi robots search-engine (eg. Googlebot, Bingbots etc), apalagi ada content tertentu yang jika dirayapi akan berdampak buruk terhadap usaha optimisasi search engine (SEO).- Kapankah kita harus menggunakan file robots.txt?

- File robots.txt dibutuhkan HANYA JIKA website mengandung content (posting) yang tidak ingin diindeks

- File robots.txt (sering salah dinamai robot.txt, – tanpa “s” sehingga berarti singular bukan jamak) diciptakan untuk disallow (membatasi) file (dan direktori) website sehingga spiders (robots) search engine tidak mengakses content tersebut.

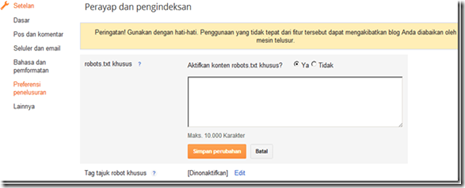

Bagaimana cara setting file robots.txt website?

- User-agent: Mediapartners-Google

Disallow:

- User-agent: *

Disallow: /search

- Sitemap: ht*p://NAMABLOG.blogspot.com/feeds/posts/default?orderby=updated

Untuk kepentingan SEO Anda bisa mengedit isi file robots.txt menjadi :

- User-agent: Mediapartners-Google

Disallow:

- User-agent: *

Disallow: /*?updated-max=*

- Sitemap: ht*p://NAMABLOG.blogspot.com/feeds/posts/default?orderby=updated

- User-agent: Mediapartners-Google

Disallow:

- User-agent: *

Disallow: /search?q=*

Disallow: /*?updated-max=*

- Sitemap: ht*p://NAMABLOG.blogspot.com/feeds/posts/default?orderby=updated

Create a robots.txt file in website

- User-agent: the robot the following rule applies to :

(terjemahannya, robot! aturan berikut ini berlaku untuk:) - Disallow: the URL you want to block

(terjemahannya : URL yang ingin diblok)

- User-agent: *

- User-agent: *

Disallow: /folder1/ - User-Agent: Googlebot

Disallow: /folder2/

- User-agent: Googlebot

Disallow: /

- User-agent: *

Disallow: /

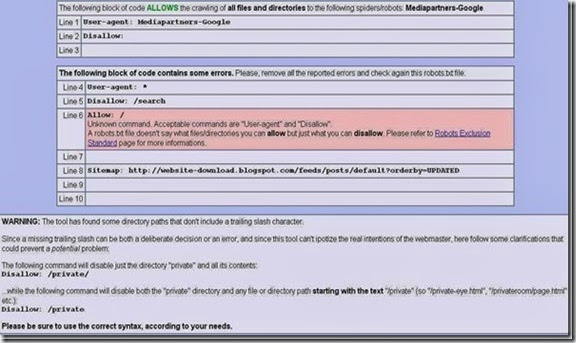

Validasi file robots.txt of website

PERINGATAN : Error ALLOW pada blog Website Design

Unknown command. Acceptable commands are "User-agent" and "Disallow".

A robots.txt file doesn't say what files/directories you can allow but just what you can disallow. Please refer to Robots Exclusion Standard page for more informations.

![Validate my Atom 1.0 feed [Valid Atom 1.0]](https://lh3.googleusercontent.com/-AHjNV40KrDw/UextTozh8GI/AAAAAAAAMjU/UG7zSHdmatc/w88-h31-no/valid-atom.jpg)